Som una Fundació que exercim el periodisme en obert, sense murs de pagament. Però no ho podem fer sols, com expliquem en aquest editorial.

Clica aquí i ajuda'ns!

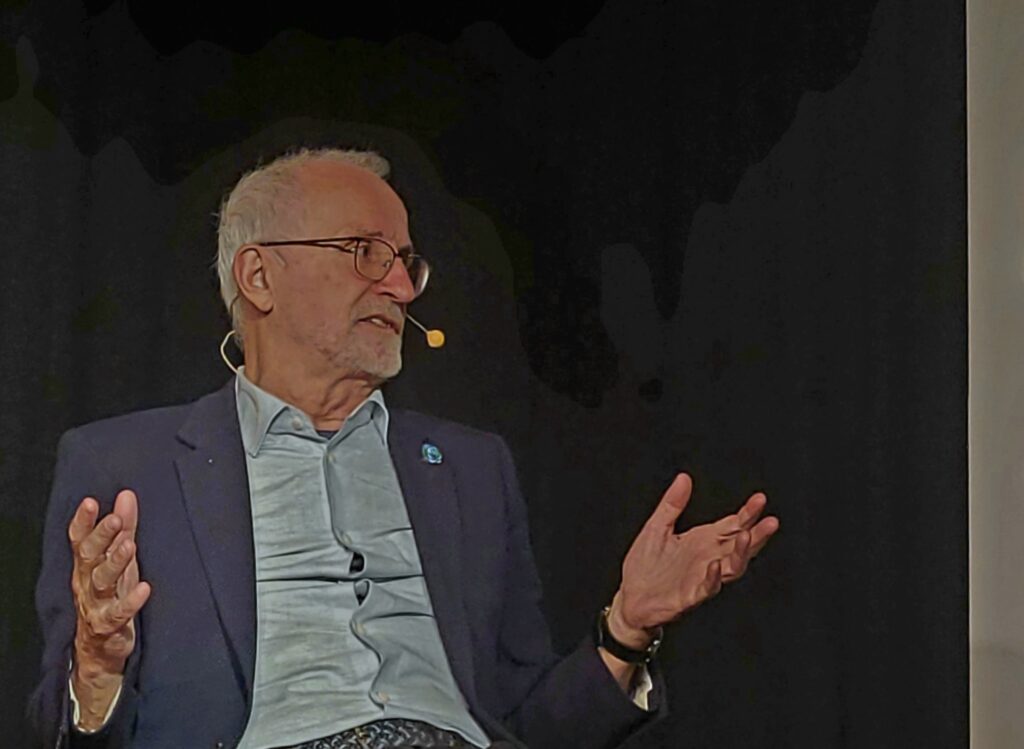

Ramon López de Mántaras i Badia (Sant Vicenç de Castellet, Bages, 1952) és professor d’investigació (emèrit) del CSIC a l’Institut d’Investigació en Intel·ligència Artificial (IIIA), del qual fou director; membre de l’Institut d’Estudis Catalans, membre d’honor de l’Associació Europea d’Intel·ligència Artificial i forma part de diferents comitès assessors per a institucions públiques i empreses americanes i europees sobre temes relacionats amb la IA. És l’autor de “100 coses que cal saber sobre intel·ligència artificial” (Ed. Cossetània).

En el llibre comenta que la comprensió del llenguatge i els coneixements de sentit comú són els principals problemes que afronta la intel·ligència artificial.

Sí. Des del punt de vista científic, crec que si volem tenir una intel·ligència artificial que sigui realment més intel·ligent que la que tenim ara, que encara és molt limitada, cal que entengui el món i tingui coneixements sobre com funciona. I una part d’aquests coneixements són els coneixements de sentit comú: predir els resultats de les teves accions, saber explicar allò que veus i entendre el llenguatge, perquè el llenguatge no s’entén si no tens els referents del món que nosaltres estem experimentant des que som petitets… Un software que hi ha en un ordinador no té interacció amb el món, només a través del que tu teclegis, però no és una interacció directa.

Es podria dir, doncs, que la intel·ligència artificial no és gaire intel·ligent, ara mateix?

És una intel·ligència molt específica, són coses molt superespecialitzades i fa molt bé les tasques per a les quals algú l’ha preparat, però per iniciativa pròpia no fa res. El cotxe autònom és el cas més típic. Hi ha programadors que programen la tasca directament o que fan un software que aprèn a fer aquella tasca a partir d’exemples i observacions, però això és molt complicat quan la tasca té moltes variables o moltes casuístiques; i el món és molt imprevisible i no pots pensar a priori en totes les situacions que es podran donar. Un software que fa això jo no el considero intel·ligent, a no ser que redefinim el concepte d’intel·ligència i el flexibilitzem i el relaxem molt. L’alternativa és programar-lo perquè aprengui quan es troba davant d’aquestes situacions, i això és molt lent. Amb la IA s’intenta dotar les màquines d’alguna de les capacitats intel·ligents que tenim els humans –com ara raonar, aprendre, generalitzar, adaptar-se a una situació nova, resoldre un problema quan aquest s’allunya d’allò que és normal, prendre decisions davant d’incerteses…– però de moment no ens n’estem sortint gaire bé, i això genera preguntes ètiques importants.

“Amb la IA s’intenta dotar a les màquines d’alguna de les capacitats intel·ligents que tenim els humans, però de moment no ens n’estem sortint gaire bé”

En aquest sentit, fa poc que la UE va aprovar una regulació sobre l’ús ètic de la IA. Creu que compleix les expectatives i tindrà una aplicació real i pràctica?

Aquesta llei té molt bones intencions i apunta cap al bon camí, però no estarà en vigor abans del 2026, perquè ha de passar un seguit de tràmits dins d’Europa. Inclou progressos importants per regular i protegir la societat i disminuir els possibles impactes negatius en la societat però, en la meva opinió, queda curta. Per exemple, la llei ni tan sols esmenta les armes letals autònomes… Estic segur que és degut al fet que els lobbies i els estats que negocien amb el mercat de les armes estan totalment en contra que es prohibeixin i, per a mi, això desprestigia molt aquesta llei. Un exemple: el sistema Lavender, que decideix quins objectius ha d’atacar l’exèrcit d’Israel. Els mateixos que van desenvolupar aquest software admeten que fa un 10% d’errors, de falsos positius; és a dir, que detecta com a possible objectiu algú que no ho és en absolut; creu que una persona pertany a Hamàs quan no hi té res a veure. El 10% de 37.000 (3.700 persones), que és la quantitat d’objectius que el sistema va determinar que tenien una alta probabilitat de ser membres de Hamàs, van ser atacats essent completament innocents. Aquest software l’ha fet una empresa d’Israel, però es podria haver fet a Europa i, amb l’entrada en vigor d’aquesta llei (2026-2027), es podria fer un Lavender 2 mentre es comercialitzi fora d’Europa. Això és escandalós. Un altre tema que queda curt és el de reconeixement facial. Aquest control massiu de la ciutadania es pot fer a la UE, tot i la llei, sempre que un jutge ho autoritzi. I, precisament a Catalunya, sabem molt bé què pot passar amb les decisions dels jutges… jo ho hauria prohibit en totes les circumstàncies.

I veu factible, amb el temps, acordar una ètica global a nivell mundial sobre IA?

Ho veig pràcticament impossible, perquè allò que és ètic per a uns, potser no ho és tan per a uns altres. En cultures diferents no hi ha una moral universal, i així difícilment hi haurà una ètica universal. Amb aquesta llei europea d’intel·ligència artificial sembla que hi ha força acceptació entre la cultura europea. Però, per exemple, a la Xina aplicaran una cosa completament diferent a la nostra… Allà, potser s’accepta el que aquí es considera no només no ètic, sinó fins i tot no legal pel que fa a la privacitat de dades o al control de la ciutadania.

Entraríem de ple en el tema de la privacitat… Què passa amb la privacitat de la gent en aquest món tan digital?

Des del moment que portes un mòbil a la butxaca, que fas cerques i compres per internet, poden arribar a saber moltes coses sobre tu, fins i tot algunes de molt íntimes. Malgrat intentar fer allò que anomeno “dieta digital”, no autoritzar i rebutjar cookies… de privacitat, gairebé no en tenim, i correm un perill bastant preocupant. La privacitat penso que, malauradament, és una batalla perduda, i les generacions més joves són encara menys conscients en aquest aspecte.

“Des del moment que portes un mòbil a la butxaca i fas cerques i compres per internet es poden arribar a saber moltes coses sobre tu; de privacitat, gairebé no en tenim, i correm un perill bastant preocupant”

La IA també s’aplica, cada vegada més, a l’assistència als humans; els denominats altaveus intel·ligents en són un exemple clar. Si fa quinze anys això semblava impossible, què podem esperar que revolucioni casa nostra en quinze més?

Quinze anys són molts anys. La línia d’aquesta IA generativa, que és tan poc fiable, crec que tocarà sostre aviat si no es fan canvis tecnològics i científics importants. Tinc la sensació que d’aquí a 15 anys o abans la IA que hi haurà serà força diferent de la que hi ha ara. Aquests models de llenguatge tipus ChatGPT crec que tenen els dies comptats, i que la bombolla d’aquests sistemes s’està començant a desinflar; a les empreses que desenvolupen aquestes tècniques els costa cada vegada més trobar finançament i inversors capaços d’assumir riscos importants com aquest… El futur de la IA crec que serà molt diferent del que hi ha ara; hi haurà tècniques noves amb elements que facilitaran preservar la veritat a través d’híbrids d’allò que es fa ara i coses que es feien abans, però millorades.

Fins a quin punt diria que la IA és fiable?

Òbviament, no ho és, i el problema és que aquesta manca de fiabilitat no es pot arreglar. Alguns diuen que la IA ‘al·lucina’. A mi no m’agrada gaire utilitzar aquesta paraula, perquè és com antropomorfitzar la IA i jo ho evito, perquè no estem parlant de persones. Aquestes últimes tendències de la IA són les que “al·lucinen” i cometen errors flagrants; abans s’utilitzaven mètodes molt diferents, que eren ‘preservadors de la veritat’ (truth preserving), basats en conceptes de la lògica matemàtica. Aquesta lògica es construeix sobre el concepte de deduir veritats a partir d’antecedents verídics, i com que la base de tot eren raonaments de veritats que conduïen a altres veritats, no ens trobàvem amb els problemes que tenim ara: una IA que es basa en analitzar grans quantitats de dades (textos, fotos, vídeos…) centenars de milions de dades a nivells pràcticament astronòmics. Com que al darrere no hi ha un mètode que preserva la veritat ens pot dir qualsevol animalada, perquè simplement genera text calculant quina és la probabilitat més alta de la següent paraula (quina és la paraula més probable que seguirà una seqüència d’altres paraules), i això fa inherentment impossible que garanteixi la veritat. La primera versió del ChatGPT, per exemple, deia que jo havia mort, perquè el que fa aquesta IA són aproximacions, i potser estadísticament molta gent nascuda al voltant dels anys cinquanta ja ha mort… Després, pots entrenar aquesta IA i corregir aquest error, però en generarà d’altres.

Quins beneficis aporta, doncs, la IA a la societat actual?

En el camp on més es veuen els beneficis de la IA és, sobretot, en aplicacions a la salut. Els sistemes d’IA ajuden molt els metges a prendre millors decisions. En diagnòstics per imatge hi ha centenars d’exemples, perquè l’ull humà veu a nivell molt global i, en canvi, la IA veu els píxels de les imatges, té un nivell de resolució molt, molt fi, i pot detectar patrons on hi ha un possible tumor que encara és imperceptible per a l’ull humà. Per tant, aquestes visions amb resolucions diferents es complementen. La IA és una molt bona eina per als metges, és una amplificació de la capacitat del metge, perquè s’incrementa molt la precisió diagnòstica. La combinació de l’anàlisi d’un metge amb l’ajut de la IA dona resultats brutals.

“En el camp on més es veuen els beneficis de la IA és, sobretot, en aplicacions a la salut”

En el sector laboral, una de les pors que s’ha extès és que la intel·ligència artificial podria ser el perfecte substitut de milers de llocs de treball. Creu que és un escenari possible?

Ja ho és però, en aquest cas, la IA és només una etapa més de l’automatització. La història del món modern passa per l’automatització, i això provoca transformacions en el mercat laboral; hi ha gent que deixa de fer el que feia per fer altres coses. Però gairebé sempre els llocs perduts es compensen per nous llocs de treball. Amb la informàtica també va passar. Amb la IA, què pot passar? Honestament, ningú no pot dir encara si es crearan prou llocs de treball nous per compensar tots aquells que s’aniran substituint. Però estic convençut que hi ha una sèrie de tasques que no podran ser substituïdes, com ara les que requereixen certa destresa, perquè les màquines no ho són gens, de destres, i en molts casos es requereix igualment una intervenció humana.

Podria posar un exemple?

Aquí caldria concretar si estem parlant de tasques o de llocs de treball sencers, perquè un mateix lloc de treball es composa de moltes tasques… Es podran automatitzar tasques de molts llocs de treball, però estic convençut que n’hi haurà moltes altres on la IA no arribarà i, per tant, s’haurà de treballar en equip. Per exemple, el radiòleg no només mira radiografies, sinó que fa moltes altres coses al llarg del dia. En aquest cas, per observar si a la radiografia d’uns pulmons hi ha o no la possibilitat d’un tumor, la IA pot ser una ajuda molt bona, però només a l’hora d’observar la imatge; en tota la resta del procés, de tenir en compte el context, antecedents, historial, valoracions, literatura científica, etc., caldrà la intervenció del metge. Per tant, la IA s’ha de veure com una eina d’ajuda. Per a mi, l’enfocament de l’impacte en el treball s’ha de veure des d’aquest punt de vista. Això no vol dir que no causi un període transitori problemàtic, perquè cal una adaptació i s’haurà de treballar una mica diferent de com ho fem ara.

“Ningú no pot dir encara si es crearan prou llocs de treball nous per compensar tots aquells que s’aniran substituint”

Pel que fa al tan popular ChatGPT, trobem un gran debat en el camp de l’educació, on hi ha grans partidaris i detractors….

Jo estaria en contra d’usar de manera estúpida el ChatGPT o de la intel·ligència artificial en general. Però al ChatGPT li pots donar la volta i fer-lo servir com a eina d’ajuda en l’ensenyament. I hi ha gent que ho està fent. Nosaltres hem parlat amb mestres sobre IA i educació i han sortit coses molt interessants com, per exemple, que als estudiants se’ls encarregui que treballin un tema –la caiguda de l’Imperi romà, Galileu o qualsevol altre– fent servir el ChatGPT. Un cop tenen els resultats del ChatGPT se’ls demana que facin una anàlisi crítica i que facin fact-checking: del que ha generat la intel·ligència artificial, què és correcte, què és incorrecte i per què… Aquest és un exercici molt bo per a l’estudiant, a més d’instructiu i pedagògic, perquè comprovaran, per experiència directa, que el ChatGPT pot generar autèntiques burrades. Per tant, potser servirà perquè ja no se’n refiïn tant. A més, hauran comprovat què és cert i què és fals sobre un determinat tema i hauran hagut de buscar fonts creïbles, i això és una excusa per aprendre coses certes i formadores.

En el seu cas, ha utilitzat en algun moment el ChatGPT per escriure parts del seu llibre?

Zero. De fet, quan el vaig començar a escriure encara no existia. Cossetània em va proposar si volia fer el llibre el 2021. En aquest sentit, penso que si ara tots ens acostumem a tenir una primera versió amb el ChatGPT que llavors ja corregirem, acabarem essent incapaços de començar des de zero un escrit. La creativitat es veurà molt afectada. És que no ens adonem de l’impacte que pot tenir, fins i tot a nivell cognitiu… I la cultura de l’esforç també es veurà afectada… Per a mi, es tracta d’una eina que, posat en una balança el positiu i el negatiu, pesa més el negatiu en aquests moments; el balanç global no m’agrada gens, però això no vol dir que no hi hagi coses positives.

“La intel·ligència artificial és una amplificació de la capacitat del metge, perquè incrementa molt la precisió diagnòstica”

Un altre àmbit que també impacta la IA és el mediambiental. El seu desenvolupament és sostenible a llarg termini?

Amb aquesta tecnologia que tenim ara, basada en el silici, segur que no. El GPT-4, per exemple, requereix una quantitat brutal de consum elèctric: mil milions de quilowatts, que són un terawatt, i això no és sostenible. També les emissions dels semiconductors, els GPUs, que són els que entrenen el GPT-4, consumeixen una quantitat molt gran d’energia. Aquest augment d’emissions preveu que la demanda d’electricitat del sector de tecnologia mundial creixi més d’un 60% entre el 2020 i el 2030. Per a mi, aquest repte del consum energètic potser acabarà essent un dels factors limitadors més importants del desenvolupament d’aquesta intel·ligència artificial.